Vous n’avez aucune idée de ce qu’est le fichier robots.txt et de ce qu’il fait pour votre site ? Avez-vous vraiment besoin de savoir ce que c’est et comment l’utiliser ? Dans cet article, nous allons parler de ce qu’est le fichier robots.txt et de la façon de l’installer sur WordPress, avec ou sans plugin gratuit comme Yoast SEO.

La première chose que je dois dire est que par défaut, WordPress crée automatiquement un fichier robots.txt pour votre site. Donc même si vous ne levez pas le petit doigt, votre site devrait déjà avoir le fichier robots.txt de WordPress.

Mais, si vous saviez cela, vous êtes probablement ici parce que vous voulez en savoir plus, ou ajouter plus de fonctionnalités (instructions) à ce fichier.

À cette fin…

…Vous êtes novice en matière de robots.txt, et vous vous sentez totalement perdu ?

Peut-être que quelqu’un dans votre équipe vous a désigné pour vous occuper de quelque chose dans le fichier robots.txt, comme “Assurez-vous que telle et telle chose est ajoutée/bloquée dans robots.txt”.

Quoi qu’il en soit, je vais faire comme si vous ne saviez rien de robots.txt, et vous dire rapidement tout ce que vous devez savoir pour commencer à utiliser ce fichier texte crucial.

Avant de commencer, je dois préciser que cet article couvre la plupart des installations de WordPress (qui se trouvent à la racine d’un domaine). Dans le cas rare où vous avez WordPress installé sur un sous-dossier ou un sous-domaine, alors comment et où vous installez robots.txt peut différer de ce que je détaille ci-dessous. Cela dit, ces mêmes principes et idées clés s’appliquent toujours.

Vous savez probablement qu’il existe des robots d’exploration du Web qui visitent les sites et indexent éventuellement les données qui s’y trouvent. On les appelle aussi des robots. Il s’agit de tout type de robot qui visite et explore les sites Web sur l’internet. Les types de robots les plus courants sont les robots des moteurs de recherche, comme ceux de Google, Bing, etc. Ils explorent les pages et aident les moteurs de recherche à les indexer et à les classer dans les SERP.

On dit qu’en arrivant sur un site, l’un des premiers fichiers que les robots des moteurs de recherche ou les robots Web sont censés rechercher est le fichier robots.txt.

Un fichier robots.txt est un simple fichier texte qui fournit des instructions aux robots des moteurs de recherche et aux crawlers web. Il a été créé au milieu des années 90 par le désir de contrôler la façon dont les robots interagissent avec les pages. Il permet aux propriétaires et aux développeurs de sites Web de contrôler la manière dont les robots peuvent interagir avec un site. Vous pouvez empêcher les robots d’accéder à certaines zones de votre site, leur montrer où se trouve votre plan de site ou retarder l’exploration de votre site.

Ainsi, d’une certaine manière, si vous ne souhaitez pas que certaines sections de votre site soient explorées, un fichier robots.txt peut indiquer aux utilisateurs-agents respectueux de la loi de ne pas visiter ces dossiers.

Certains robots d’exploration ont été conçus à des fins malveillantes et il se peut qu’ils ne respectent pas les normes établies par le protocole d’exclusion des robots.

Cela dit, si vous avez des informations sensibles sur une certaine partie de votre site, vous pouvez prendre des mesures supplémentaires pour restreindre l’accès à ces données, par exemple en installant un système de mots de passe.

Pour la plupart des installations WordPress, le fichier robots.txt se trouve sur le domaine racine. Autrement dit, pour la plupart des sites WordPress (qui sont installés dans le répertoire racine d’un domaine), le fichier robots.txt se trouve à l’adresse /robots.txt.

Ainsi, par exemple, ce site (seointel.com) a une installation WordPress à la racine de son domaine. Son fichier robots.txt se trouve donc à l’adresse /robots.txt (https://seointel.com/robots.txt).

Si vous n’avez pas de fichier robots.txt ou si vous avez simplement le fichier par défaut de WordPress, les robots peuvent explorer toutes les pages de votre site Web et ils ne sauront pas quelles zones ils ne doivent pas explorer. Cela devrait convenir aux personnes qui débutent avec un blog ou aux sites qui n’ont pas beaucoup de contenu. Cependant, pour les sites qui ont beaucoup de contenu et les sites qui traitent des informations privées, un fichier robots.txt est nécessaire.

Pour les sites qui ont beaucoup de contenu, il serait bon de mettre en place un fichier robots.txt qui détermine quels sites ne doivent pas être explorés. Pourquoi ? Parce que les robots des moteurs de recherche ont généralement un quota d’exploration, un taux d’exploration ou un budget d’exploration pour chaque site Web. Les robots ne peuvent explorer qu’un certain nombre de pages par exploration et s’ils n’ont pas fini d’explorer toutes vos pages, ils les reprendront lors des prochaines sessions d’exploration. Cela signifie que pour les grands sites, l’exploration du site peut être plus lente et entraîner une indexation plus lente du contenu nouveau ou mis à jour. Ce problème peut être résolu en empêchant les robots d’explorer les pages non importantes de votre site, comme les pages d’administration, les fichiers de plugins et le dossier des thèmes.

En procédant ainsi, vous pouvez optimiser votre site et vous assurer que les robots n’explorent que les pages importantes de votre site et que les nouvelles pages sont explorées et indexées aussi rapidement que possible.

Il arrive également que le contenu dupliqué ne puisse être évité sur un site. Certains choisissent d’ajouter la page dans le fichier robots.txt afin que les pages dupliquées ne soient pas explorées.

Un autre cas est celui où votre site connaît un trafic de robots élevé qui peut avoir un impact sur l’utilisation ou les performances de votre serveur. Vous pouvez empêcher certains robots d’explorer votre site ou définir un délai d’exploration. Cela permet d’améliorer les performances de votre site.

L’ajout de vos plans de site à votre fichier robot.txt aide également le robot de Google à trouver votre plan de site et à explorer les pages de votre site, bien que cet ajout ne soit souvent plus nécessaire car les plans de site peuvent être configurés dans la Google Search Console.

Le fichier robots.txt comporte deux commandes principales. La directive User-agent et disallow.

En dehors de ces deux commandes courantes, il existe également la commande Allow qui se passe de commentaires. Par défaut, tout ce qui se trouve sur votre site est marqué comme Allow, il n’est donc pas vraiment nécessaire de l’utiliser. Elle peut toutefois être utilisée lorsque vous interdisez l’accès au dossier parent mais autorisez l’accès aux sous-dossiers ou à un dossier enfant.

Il existe également des commandes pour Crawl-delay et Sitemap.

Il arrive également que vous ne souhaitiez pas qu’une page soit indexée et que la meilleure solution ne soit pas simplement de l’interdire dans le fichier robots txt. La commande Disallow n’est pas la même que la balise noindex. Si la commande disallow empêche les robots d’explorer un site, elle n’empêche pas nécessairement l’indexation d’une page. Si vous souhaitez qu’une page ne soit pas indexée et n’apparaisse pas dans les résultats de recherche, la meilleure solution consiste à utiliser une balise noindex.

Le meilleur exemple est peut-être votre propre exemple. Puisque vous lisez ceci, vous avez probablement un site WordPress. Allez dans le fichier robots.txt de ce site – ajoutez /robots.txt à votre domaine racine. (Si vous n’avez pas encore de site WordPress, suivez simplement les exemples ci-dessous).

Que voyez-vous ?

Vous pouvez voir un fichier vide, ce qui n’est pas le mieux, mais il n’y a techniquement rien de mal à cela. Cela signifie simplement que les crawlers peuvent aller où ils le peuvent.

Agent utilisateur : *

Autoriser : /

Ainsi, les instructions de robots.txt fonctionnent de la manière suivante : il y a un crawler web ou un agent utilisateur (cela peut être pour tous les agents utilisateurs ou pour ceux qui sont spécifiquement nommés), suivi à la ligne suivante par une certaine instruction (généralement pour autoriser ou interdire certains dossiers ou fichiers).

L’astérisque (*) signifie “tous”, c’est-à-dire tous les agents utilisateurs, et la barre oblique (/) signifie le domaine. Ainsi, ces deux lignes de code disent effectivement : “Tous les agents utilisateurs sont autorisés partout sur ce domaine”.

Croyez-le ou non, celui-ci a exactement les mêmes implications qu’un fichier robots.txt vierge et est souvent le fichier robots.txt par défaut.

Examinons un exemple légèrement plus compliqué…

Agent utilisateur : *

Disallow : /wp-admin/

Nous savons que l’astérisque (*) signifie tous les bots/crawlers/agents utilisateurs.

Le dossier wp-admin n’est pas autorisé.

Il s’agit donc d’un appel (une instruction) qui empêche les robots des moteurs de recherche et autres bots de ramper et de parcourir le dossier wp-admin. (Cela est compréhensible, car le dossier wp-admin est généralement une zone sécurisée, réservée à la connexion, d’une installation WordPress).

Si vous disposez d’une zone d’accès payant, d’une page de téléchargement ou de fichiers privés qui ne sont pas protégés par un mot de passe, cette page de téléchargement pourrait être visitée par quelqu’un utilisant un navigateur Chrome, qui, je le soupçonne, alerterait Googlebot en disant : “Hé, cette personne a laissé sa zone payante grande ouverte.”

Ensuite, Googlebot pourrait venir et indexer sans le savoir votre zone payante.

Maintenant, les chances que quelqu’un trouve votre zone d’accès payant via une recherche Google sont faibles… à moins peut-être qu’il ait une connaissance des opérateurs de moteurs de recherche et qu’il sache ce qu’il faut rechercher.

Agent utilisateur : *

Refuser : /wp-admin/

Agent utilisateur : Exabot

Disallow : /

Agent utilisateur : NCBot

Refuser : /

Nous savons déjà que tous les robots ont pour instruction de ne pas passer par le dossier wp-admin. Mais nous avons également des instructions supplémentaires pour le champ user-agent – Exabot et user-agent NCBot.

Cela signifie que vous limitez l’accès des robots à ces deux agents utilisateurs spécifiques.

Remarquez que pour Exabot et NCBot, même si les instructions de rejet sont identiques, elles sont toujours associées à l’un des deux.

Et, remarquez qu’il y a une ligne blanche après l’instruction (disallow) pour tous les user-agents, une ligne blanche après l’instruction (disallow) pour Exabot, et vraisemblablement, une ligne blanche après l’instruction (disallow) pour NCBot.

En effet, les règles du fichier robots.txt précisent que si vous avez une instruction pour des agents utilisateurs spécifiques, ces derniers doivent avoir leur propre appel (être nommés spécifiquement) et, sur la ou les lignes suivantes, lister les instructions pour cet agent utilisateur.

En d’autres termes, vous ne pouvez pas regrouper des user-agents spécifiques ou attribuer des instructions générales à un groupe d’user-agents spécifiques. Vous pouvez utiliser l’astérisque (*) pour appeler tous les user-agents, mais vous ne pouvez pas grouper des user-agents spécifiques sans utiliser l’exemple callout-next-line-instruction ci-dessus.

En gros, il doit y avoir une ligne vide après la dernière instruction pour un (ou tous les) user-agents, suivie de l’appel d’un autre user-agent (suivi d’une instruction sur la ligne suivante).

Agent-utilisateur : *

Disallow : /wp-admin/

Autoriser : /wp-admin/admin-ajax.php

Ne pas accepter : /wp-snapshots

Ne pas accepter : /trackback

Ainsi, tous les agents utilisateurs ne sont pas autorisés à accéder à wp-admin, à l’exception de l’accès à un fichier spécifique de wp-admin (admin-ajax.php), et de toute url commençant à la racine par wp-snapshots ou trackback.

Utilisateur-agent : *

Disallow : /wp-admin/

Autoriser : /wp-admin/admin-ajax.php

Ne pas accepter : /wp-snapshots

Ne pas accepter : /trackback

Plan du site : https://example.org/sitemap.xml

Plan du site : https://example.org/sitemap.rss

Cet exemple est la suite de celui utilisé dans l’exemple précédent, avec deux lignes supplémentaires indiquant aux robots de recherche (ou web-crawlers) le chemin d’accès au fichier des sitemaps RSS et XML.

Il est possible d’en faire un peu plus avec le fichier robots.txt, mais je pense que ces exemples sont suffisants pour vous permettre de commencer.

Donc, comme je l’ai mentionné plus tôt, votre site WP peut déjà avoir un fichier robots.txt qui a été ajouté lors de l’installation (vérifiez simplement yoursite.com/robots.txt).

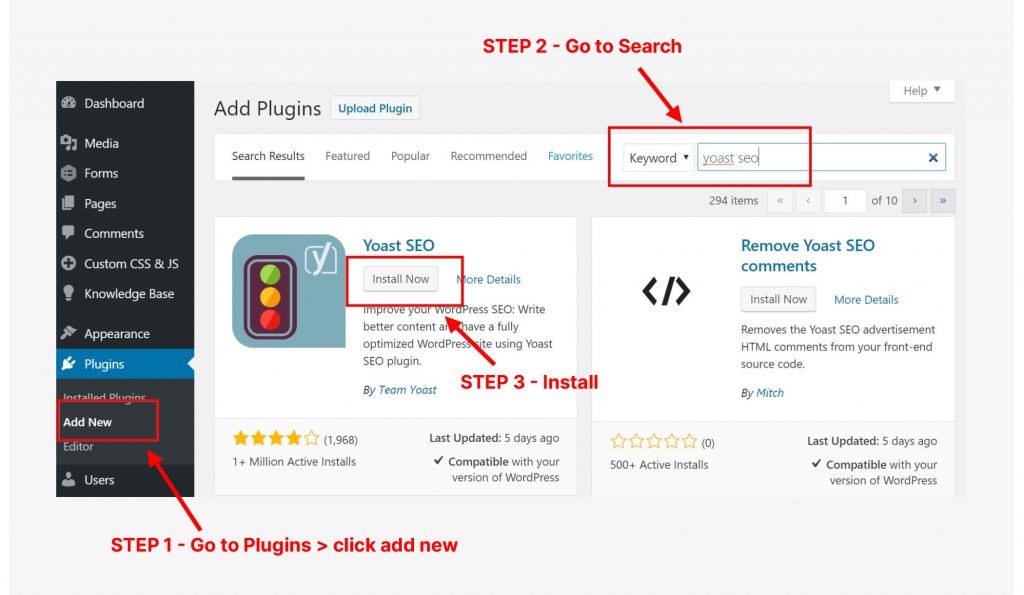

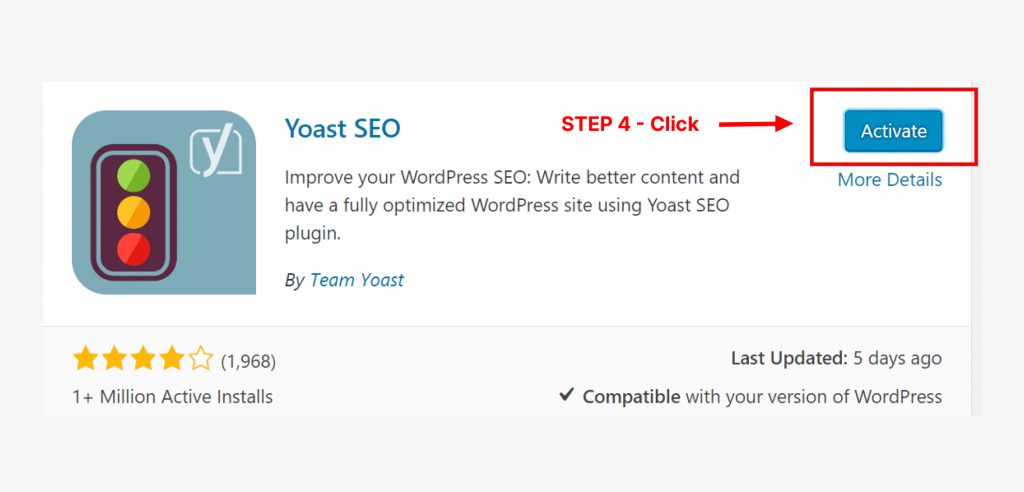

Cependant, vous pouvez souhaiter le personnaliser ou lui donner certaines fonctionnalités. Il y a généralement deux façons d’installer (ou de modifier) un fichier robots.txt sur une installation WordPress – l’une en utilisant un plugin, l’autre sans l’utilisation d’un plugin :

Maintenant que vous avez installé Yoast SEO, voici les étapes que vous pouvez suivre pour modifier ou installer un fichier robots.txt. (Note : si Yoast a changé depuis le moment où j’écris ceci, certaines des étapes ci-dessous peuvent être différentes, mais je crois que Yoast SEO aura toujours une fonction robots.txt).

Etape 1 : Savoir quels changements vous voulez faire

C’est clair : vous voulez modifier/modifier (ou ajouter) un fichier robots.txt avec certaines instructions. Assurez-vous de savoir quelles sont ces instructions.

Étape 2 : Important : Sauvegardez votre fichier robots.txt (s’il y en a un)

C’est simple : il suffit d’accéder à votre fichier robots.txt (site.com/robots.txt) et de l’enregistrer sur votre ordinateur en cliquant sur Ctrl + S (ou toute autre combinaison de votre clavier pour enregistrer un fichier).

Bien sûr, ceci est fait juste au cas où une erreur serait commise.

Étape 3 : Connectez-vous à votre site Web WordPress.

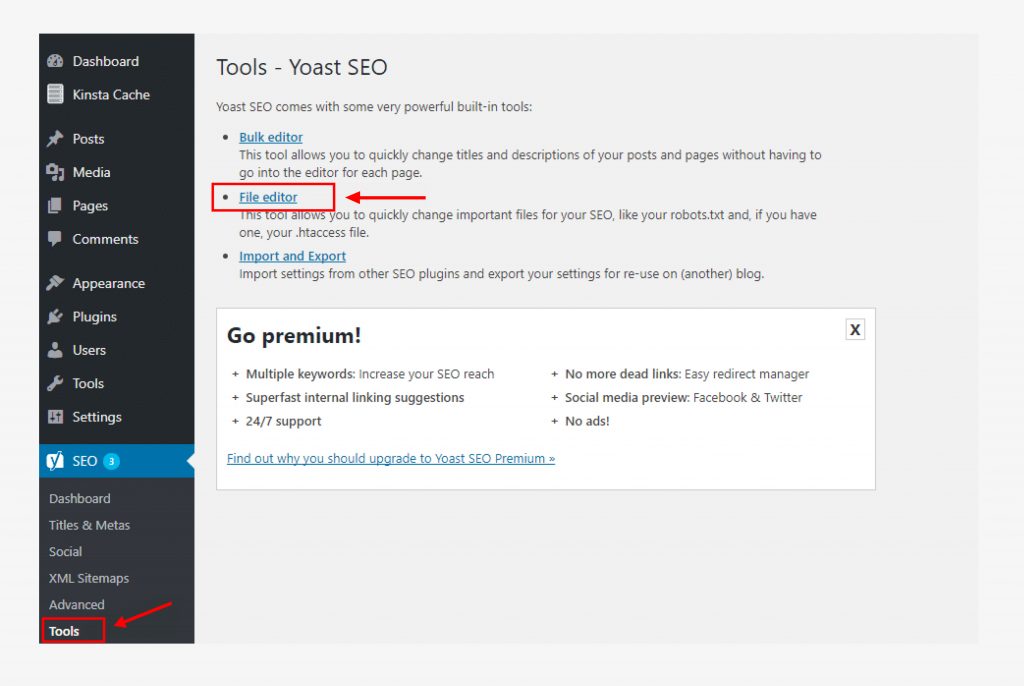

Étape 4 : Cliquez sur SEO sur le côté gauche du tableau de bord. (Voir l’image ci-dessous).

Étape 5 : Cliquez sur Outils dans les paramètres de référencement.

Étape 6 : Activez l’édition de fichiers et cliquez sur l’éditeur de fichiers.

Cette option n’apparaîtra pas si elle est désactivée.

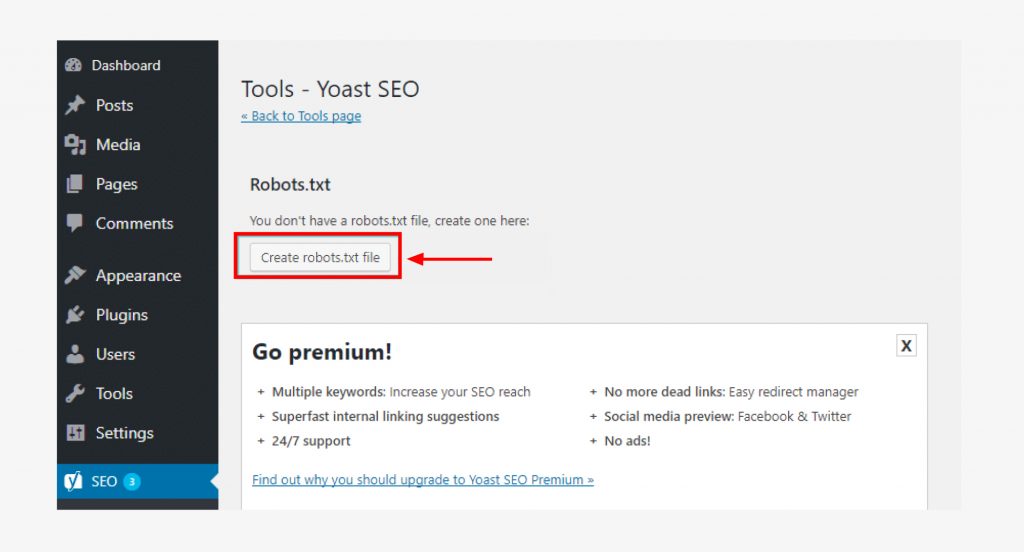

Étape 7 : Apportez les modifications à votre fichier robots.txt.

Vous pouvez le faire en suivant les exemples ci-dessus, ou en utilisant toute autre instruction spécifique que vous souhaitez mettre en avant.

Étape 8 : Sauvegardez ces changements.

Cela devrait être terminé ! Passez à la section ci-dessous pour vérifier et tester votre fichier robots.txt.

Rappelez-vous que lors de son installation, WordPress a probablement créé un fichier robots.txt virtuel. Recherchez-le lorsque vous allez dans les dossiers de votre site.

Étape 1 : Assurez-vous de savoir quelles modifications vous souhaitez apporter, ou ce que vous voulez voir figurer dans votre fichier robots.txt.

Étape 2 : Important : Faites une sauvegarde de votre fichier robots.txt. Allez dans votre fichier robots.txt (site.com/robots.txt) et enregistrez ce fichier sur votre ordinateur. Ainsi, si vous commettez une erreur plus tard, vous aurez une version antérieure à laquelle vous pourrez revenir.

Étape 3 : à l’aide du protocole de transfert de fichiers (FTP), du fichier cPanel ou d’une autre solution de gestion de fichiers, connectez-vous à la racine de votre domaine (dossier racine) et modifiez (ou créez) un fichier robots.txt.

(Vous pouvez également utiliser un éditeur de texte pour créer un fichier texte sur votre ordinateur local, y mettre les instructions que vous souhaitez, l’enregistrer sous le nom de robots.txt, puis le télécharger).

Enregistrez ce fichier avec le nom de fichier : robots.txt

Étape 3 : si vous avez créé ce fichier robots.txt sur votre ordinateur, téléchargez-le à la racine de votre domaine.

Étape 4 : Vérifiez que ce fichier robots.txt est présent. Vous pouvez le faire en vous rendant sur yoursite.com/robots.txt.

Lorsqu’il s’agit de codage, il n’y a pas de place pour les erreurs, sinon les robots n’exécuteront pas les instructions que vous souhaitez.

C’est pourquoi vous devez valider ou vérifier votre fichier.

Vous pouvez simplement faire une recherche Google pour trouver un validateur ou un vérificateur de robots.txt. Il existe un certain nombre d’options gratuites.

Pour ajouter des instructions à votre fichier robots.txt, il suffit de suivre les étapes ci-dessus (via un plugin ou par FTP).

Lorsque vous avez terminé, effectuez un test final en utilisant un validateur ou un vérificateur de robots.txt.

Au début de cet article, je vous ai demandé si vous vous sentiez perdu au sujet de robots.txt sur les sites WordPress. J’espère que les choses sont un peu plus claires pour vous. Rappelez-vous : robots.txt est un simple fichier texte qui indique aux robots de recherche (utilisateurs-agents) où ils peuvent et ne peuvent pas aller.

Bien que le fichier robots.txt soit probablement déjà présent sur votre installation WordPress, vous pouvez le modifier en utilisant un plugin WordPress (comme Yoast SEO) ou via le système de gestion de fichiers de votre hébergeur. J’espère qu’à travers mon article, vous avez une meilleure idée de la façon de le faire sur votre site.

Il y a beaucoup d’utilisations pour le fichier robots.txt. Bien qu’il ne s’agisse pas vraiment d’un fichier pour le référencement et qu’il n’affecte pas directement le classement, il permet de s’assurer que votre site et les bonnes pages sont explorés, indexés, classés pour vos termes cibles dans les résultats des moteurs de recherche et qu’ils gagnent du trafic dans les moteurs de recherche. Ceci, en soi, est une raison suffisante pour configurer votre fichier robots.txt pour votre site WordPress.

Vous cherchez d’autres was pour vous aider dans vos stratégies d’optimisation des moteurs de recherche et pour gagner du trafic organique sur votre site ? Vous voulez devenir un expert en référencement et vous cherchez d’autres informations sur le référencement ? Consultez nos autres contenus sur le référencement et laissez-nous vous aider à être classé sur Google et les autres principaux moteurs de recherche.