¿No tienes idea de qué robots.txt es y qué hace por tu sitio? ¿Realmente necesitas saber qué es y cómo usarlo? En este artículo, hablamos sobre qué es robots.txt y cómo instalar robots.txt en WordPress, con o sin un plugin gratuito como Yoast SEO.

Lo primero que debo decir es que, de forma predeterminada, WordPress crea automáticamente un archivo .txt robots predeterminado para su sitio. Entonces, incluso si no mueve un dedo, su sitio ya debería tener un archivo de robots.txt de WordPress.

Pero, si lo supiera, presumiblemente está aquí porque desea saber más o agregar más funcionalidad (instrucciones) a este archivo.

Con ese fin…

… ¿Eres nuevo en los robots.txt y te sientes totalmente perdido?

Tal vez alguien de su equipo lo designó para que se encargue de algo en el archivo .txt robots, como “Asegúrese de que tal y tal se agregue / bloquee en robots.txt”.

Cualquiera que sea el caso, voy a fingir que no sabes nada sobre robots.txt, y rápidamente te diré todo lo que necesitas saber para comenzar con este archivo de texto crucial.

Antes de comenzar, debo decir que este artículo cubre la mayoría de las instalaciones de WordPress (que están en la raíz de un dominio). En el raro caso de que tenga WordPress instalado en una subcarpeta o subdominio, entonces cómo y dónde instale robots.txt puede diferir de lo que detallo a continuación. Dicho esto, estos mismos principios e ideas clave todavía se aplican.

Probablemente sepa que hay rastreadores web que visitan sitios y posiblemente indexan los datos que se encuentran en esos sitios. Estos también se llaman robots. Son cualquier tipo de bot que visita y rastrea sitios web en Internet. El tipo más común de robot son los robots de los motores de búsqueda o los rastreadores de motores de búsqueda como los de Google, Bing, etc. Rastrean páginas y ayudan a los motores de búsqueda a indexar las páginas y clasificarlas en los SERP.

Se dice que, al llegar a un sitio, uno de los primeros archivos que se supone que los rastreadores de motores de búsqueda o rastreadores web deben buscar es el archivo robots.txt.

Un archivo robots.txt es un archivo de texto simple que proporciona instrucciones para los rastreadores de motores de búsqueda y los rastreadores web. Fue creado a mediados de los años 90 por el deseo de controlar cómo interactúan los robots con las páginas. Permite a los propietarios y desarrolladores web la capacidad de controlar cómo los robots pueden interactuar con un sitio. Puede bloquear el acceso de los robots a áreas particulares de su sitio, mostrarles dónde se puede acceder a su mapa del sitio o causar un retraso en el rastreo de su sitio.

Entonces, en cierto modo, si hay algunas secciones de su sitio que no desea que se rastreen, un archivo robots.txt puede indicar a los agentes de usuario permanentes que no visiten esas carpetas.

Hay algunos rastreadores que han sido diseñados para fines traviesos, y esos rastreadores pueden no cumplir con los estándares establecidos por el Protocolo de exclusión de robots.

Dicho esto, si tiene información confidencial en una cierta parte de su sitio, es posible que desee tomar medidas adicionales para restringir el acceso a esos datos, como instalar un sistema de contraseñas.

Para la mayoría de las instalaciones de WordPress, el archivo robots.txt está en el dominio raíz. Es decir, para la mayoría de los sitios de WordPress (que están instalados en el directorio raíz de un dominio), el archivo robots.txt se puede encontrar en /robots.txt.

Así, por ejemplo, este sitio (seointel.com) tiene una instalación de WordPress en la raíz de su dominio. Por lo tanto, su archivo robots.txt se puede encontrar en /robots.txt (https://seointel.com/robots.txt)

Si no tiene un archivo robots.txt o si solo tiene el archivo predeterminado de WordPress, los rastreadores pueden rastrear todas las páginas de su sitio web y no sabrían qué áreas no deben rastrear. Esto debería estar bien para aquellos que recién comienzan con un blog o sitios que no tienen mucho contenido. Sin embargo, para los sitios que tienen mucho contenido y los sitios que manejan información privada, se necesitaría un archivo .txt robots.

Para los sitios que tienen mucho contenido, sería una buena práctica configurar un archivo robots.txt que establezca qué sitios no rastrear. ¿Por qué? Esto se debe a que los bots de los motores de búsqueda generalmente tienen una cuota de rastreo, una tasa de rastreo o un presupuesto de rastreo para cada sitio web. Los bots solo pueden rastrear un cierto número de páginas por rastreo y, si no terminan de rastrear todas sus páginas, reanudarán el rastreo en las próximas sesiones de rastreo. Esto significa que para sitios grandes, el rastreo del sitio puede ser más lento y causar una indexación más lenta del contenido nuevo o actualizado. Este problema se puede solucionar impidiendo que los rastreadores rastreen páginas sin importancia de su sitio, como las páginas de administración, los archivos de complementos y la carpeta de temas.

Al hacer esto, puede optimizar su sitio y asegurarse de que los robots solo rastreen páginas importantes de su sitio y que las nuevas páginas se rastreen e indexen lo más rápido posible.

También hay casos en los que no se puede evitar el contenido duplicado en un sitio. Algunos optan por agregar la página en los robots.txt para que las páginas duplicadas no se rastreen.

Otra es cuando su sitio está viendo un alto tráfico de bots que puede estar afectando el uso de su servidor o el rendimiento del servidor. Puede bloquear a ciertos bots para que no rastreen su sitio o puede establecer un retraso de rastreo. Esto ayuda a mejorar los problemas de rendimiento de su sitio.

Agregar sus sitemaps a su archivo robot.txt también ayuda al bot de Google a encontrar su mapa del sitio y rastrear las páginas de su sitio, aunque esto a menudo ya no se agrega, ya que los sitemaps se pueden configurar en Google Search Console.

El archivo robots.txt tiene dos comandos principales. La directiva User-agent y disallow.

Aparte de esos dos comandos comunes, también está el comando Permitir que habla por sí mismo y, como valor predeterminado, todo en su sitio está marcado como Permitir, por lo que no es realmente necesario usarlo. Sin embargo, esto se puede usar cuando no permite el acceso a la carpeta principal, pero permite el acceso a subcarpetas o una carpeta secundaria.

También hay comandos para Crawl-delay y Sitemap.

También hay casos en los que no desea que una página se indexe y el mejor curso de acción puede no ser simplemente no permitir el archivo txt de robots. El comando Disallow no es lo mismo que la etiqueta noindex. Si bien el comando no permitir impide que los rastreadores rastreen un sitio, no necesariamente impide que una página se indexe. Si desea que una página no se indexe y no aparezca en los resultados de búsqueda, el mejor curso de acción será usar una etiqueta noindex.

Quizás el mejor ejemplo sea su propio ejemplo. Ya que estás leyendo esto, probablemente tengas un sitio de WordPress. Vaya al archivo robots.txt real de ese sitio: agregue /robots.txt a su dominio raíz. (Si aún no tiene un sitio de WordPress, simplemente siga los ejemplos a continuación).

¿Qué ves?

Es posible que vea un archivo en blanco o un archivo vacío, que no es el mejor, pero técnicamente no hay nada de malo en eso. Solo significa que los rastreadores pueden ir a donde puedan.

Agente de usuario: *

Permitir: /

Por lo tanto, la forma en que funcionan las instrucciones .txt los robots es que hay un rastreador web o una llamada de agente de usuario (esto puede ser para todos los agentes de usuario o con nombres específicos), seguido en la siguiente línea por una cierta instrucción (generalmente para permitir o no permitir ciertas carpetas o archivos).

El asterisco (*) implica todo, es decir, todos los agentes de usuario, y la barra diagonal (/) significa el dominio. Por lo tanto, estas dos líneas de código están diciendo efectivamente: “Todos los agentes de usuario están permitidos en todas partes en este dominio”.

Lo creas o no, este tiene exactamente las mismas implicaciones que un archivo robots.txt en blanco y, a menudo, es el archivo .txt robots predeterminado.

Veamos uno un poco más complicado…

Agente de usuario: *

No permitir: /wp-admin/

Sabemos que el asterisco (*) significa todos los bots/rastreadores/agentes de usuario.

La carpeta wp-admin no está permitida.

Por lo tanto, esta es una llamada (una instrucción) que evita que los rastreadores de motores de búsqueda y otros bots rastreen y pasen por la carpeta wp-admin. (Esto es comprensible, porque la carpeta wp-admin suele ser un área segura de solo inicio de sesión de una instalación de WordPress).

Si tiene un área de acceso de pago, una página de descarga o archivos privados que no están protegidos con contraseña, esa página de descarga podría ser visitada por alguien que use un navegador Chrome, lo que sospecho que alertaría a Googlebot, diciendo: “Oye, esta persona dejó su área de pago abierta de par en par”.

Entonces, Googlebot podría venir e indexar sin saberlo su área de pago.

Ahora, las posibilidades de que alguien encuentre su área de acceso pagado a través de una búsqueda en Google son bajas … a menos que tal vez tengan un conocimiento de los operadores de motores de búsqueda y sepan qué buscar.

Agente de usuario: *

No permitir: /wp-admin/

Agente de usuario: Exabot

No permitir: /

Agente de usuario: NCBot

No permitir: /

Sabemos desde antes que todos los bots tienen instrucciones de no pasar por la carpeta wp-admin. Pero también tenemos instrucciones adicionales para el campo user-agent: Exabot y user-agent NCBot.

Esto significa que restringe el acceso de bots a esos 2 agentes de usuario específicos.

Tenga en cuenta que para Exabot y NCBot, aunque las instrucciones de no permitir son idénticas, todavía están emparejadas con cualquiera de los dos.

Y, observe que hay una línea en blanco después de la instrucción (no permitir) para todos los agentes de usuario, una línea en blanco después de la instrucción (no permitir) para Exabot y, presumiblemente, una línea en blanco después de la instrucción (no permitir) para NCBot.

Esto se debe a que las reglas para robots.txt especifican que si tiene una instrucción para agentes de usuario específicos, entonces esos agentes de usuario deben tener su propia llamada (tener un nombre específico) y, en las siguientes líneas, enumerar las instrucciones para ese agente de usuario.

En otras palabras, no puede agrupar agentes de usuario específicos o, por lo general, asignar instrucciones a un grupo de agentes de usuario específicos. Puede usar el asterisco (*) para llamar a todos los agentes de usuario, pero de lo contrario no puede agrupar agentes de usuario específicos sin usar el ejemplo de instrucción de llamada siguiente línea anterior.

Entonces, básicamente, tiene que haber una línea en blanco después de la última instrucción para uno (o todos) los agentes de usuario seguido de la llamada de otro agente de usuario (seguida de una instrucción en la siguiente línea).

Agente de usuario: *

No permitir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

No permitir: /wp-snapshots

No permitir: /trackback

Por lo tanto, todos los agentes de usuario no están permitidos de wp-admin, con la excepción de que se les permite rastrear un archivo específico en wp-admin (admin-ajax.php) y no se les permite desde cualquier URL que comience desde la raíz con wp-snapshots o trackback.

Agente de usuario: *

No permitir: /wp-admin/

Permitir: /wp-admin/admin-ajax.php

No permitir: /wp-snapshots

No permitir: /trackback

mapa del sitio: https://example.org/sitemap.xml

mapa del sitio: https://example.org/sitemap.rss

Este ejemplo es una continuación del utilizado en el ejemplo anterior, con dos líneas agregadas que indican a los robots de búsqueda (o rastreadores web) la ruta del archivo para los sitemaps RSS y XML.

Hay un poco más que se puede hacer con robots.txt, pero creo que estos ejemplos son suficientes para que comiences.

Por lo tanto, como mencioné anteriormente, es posible que su sitio WP ya tenga un archivo robots.txt que se agregó durante la instalación (solo verifique yoursite.com/robots.txt).

Sin embargo, es posible que desee personalizarlo o darle alguna funcionalidad. En general, hay 2 formas de instalar (o editar) un archivo robots.txt en una instalación de WordPress, una usando un complemento y la otra sin el uso de un complemento:

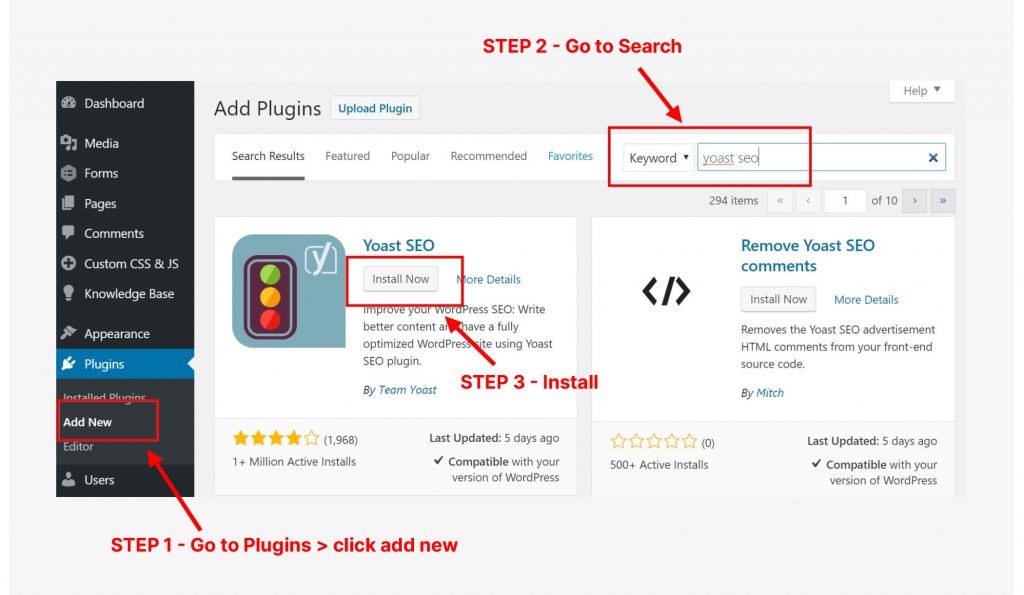

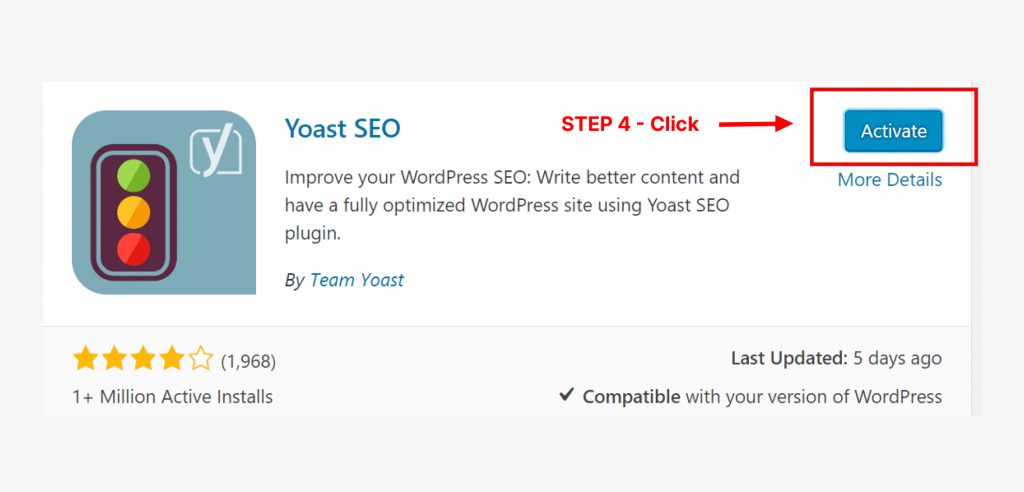

Ahora que tiene Yoast SEO instalado, estos son los pasos que puede seguir para editar o instalar un archivo robots.txt. (Nota: si Yoast ha cambiado desde el momento en que escribo esto, algunos de los pasos a continuación pueden ser diferentes, pero creo que Yoast SEO todavía tendrá una función .txt robots).

Paso 1: Sepa qué cambios le gustaría hacer

Esto está claro: desea cambiar / editar (o agregar) un archivo robots.txt con ciertas instrucciones. Asegúrese de saber cuáles son.

Paso 2: Importante: Haga una copia de seguridad de sus robots.txt archivo (si hay uno)

Esto es simple: simplemente vaya a su archivo robots.txt (site.com/robots.txt) y guarde ese archivo en su computadora haciendo clic en Ctrl + S (o cualquiera que sea la combinación en su teclado para guardar un archivo).

Por supuesto, esto se hace en caso de que se cometa un error.

Paso 3: Inicie sesión en su sitio web de WordPress.

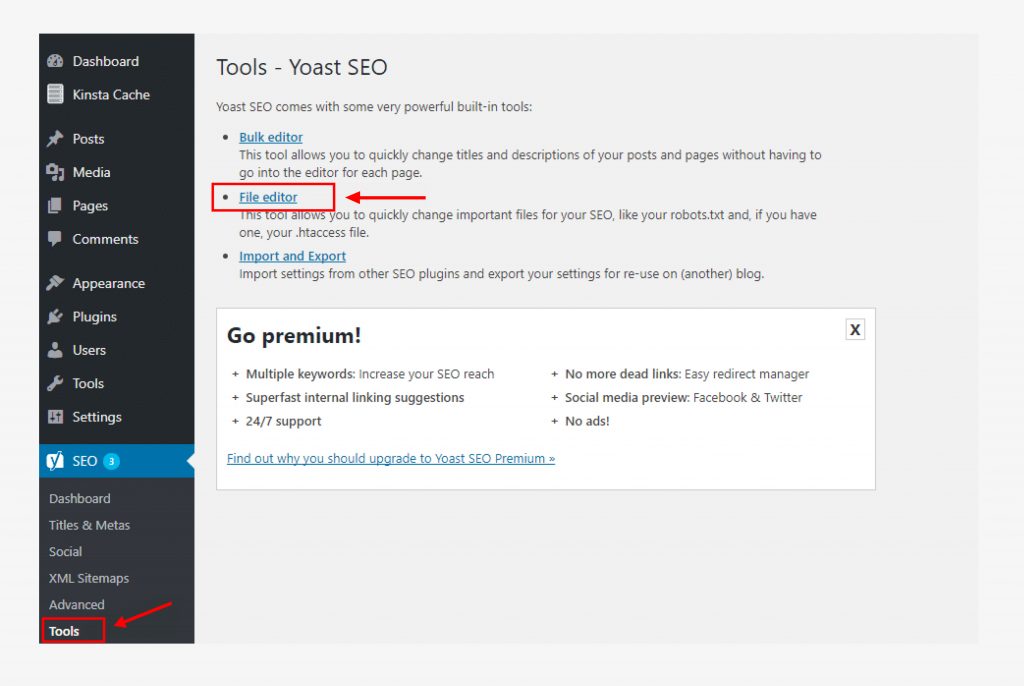

Paso 4: Haga clic en SEO en el lado izquierdo del tablero. (Vea la imagen a continuación.)

Paso 5: Haga clic en Herramientas en la configuración de SEO.

Paso 6: Habilite la edición de archivos y haga clic en el editor de archivos.

Esta opción no aparecerá si está deshabilitada.

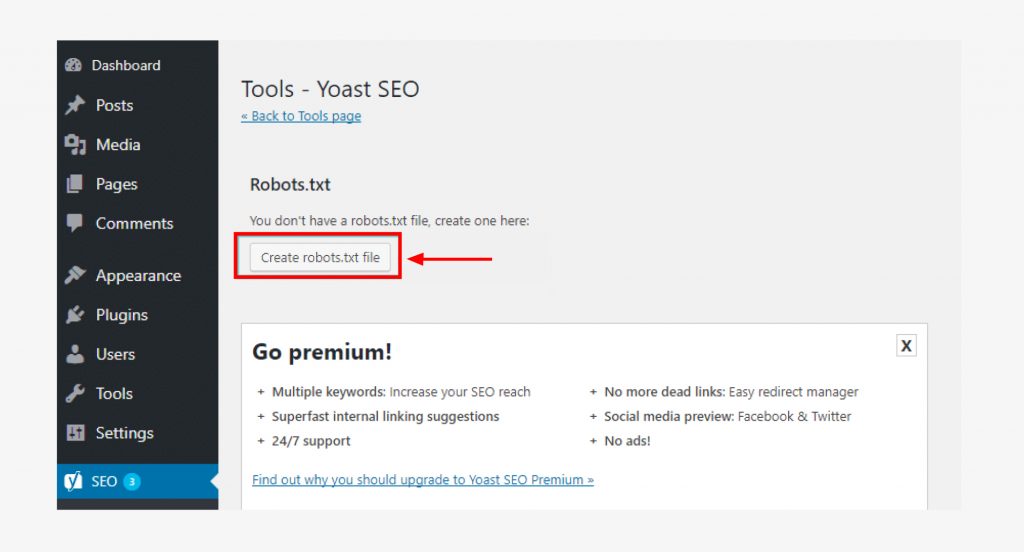

Paso 7: Crea los cambios en el archivo .txt tus robots.

Puede hacerlo siguiendo los ejemplos anteriores o utilizando cualquier otra instrucción específica que desee presentar.

Paso 8: Guarde estos cambios.

¡Eso debería ser todo! Vaya a la sección a continuación sobre la verificación y prueba del archivo .txt sus robots.

Recuerde que cuando se instaló, WordPress probablemente creó un archivo .txt robots virtuales. Busque esto cuando vaya a las carpetas de su sitio.

Paso 1: Asegúrese de saber qué cambios le gustaría hacer o qué desea en su archivo .txt robots.

Paso 2: Importante: Haga una copia de seguridad del archivo .txt sus robots. Simplemente vaya al archivo .txt sus robots (site.com/robots.txt) y guarde ese archivo en su computadora. Al hacer esto, si más adelante, comete un error, tiene una versión anterior a la que volver.

Paso 3: Usando el Protocolo de transferencia de archivos (FTP), el archivo cPanel u otra solución de administración de archivos, inicie sesión en la raíz de su dominio (carpeta raíz) y edite (o cree) un archivo robots.txt.

(Alternativamente, puede usar un editor de texto para crear un archivo de texto en su computadora local, ingresar las instrucciones que desee, guardarlo como robots.txt y luego cargarlo).

Guarde este archivo con el nombre de archivo: robots.txt

Paso 3: Si creaste este archivo robots.txt en tu computadora, cárgalo en la raíz de tu dominio.

Paso 4: Asegúrese de que este archivo robots.txt esté allí. Puedes hacerlo yendo a yoursite.com/robots.txt

Cuando se trata de codificación, no hay espacio para errores, de lo contrario, los robots no realizarán las instrucciones que desea.

Es por eso que necesita validar o verificar su archivo.

Simplemente puede hacer una búsqueda en Google de un .txt validador o verificador de robots. Hay una serie de opciones gratuitas disponibles.

Para agregar instrucciones a su archivo .txt robots, simplemente siga los pasos anteriores (ya sea a través de un complemento o FTP).

Cuando haya terminado, haga una prueba final utilizando un validador o verificador de robots.txt.

Al principio de este artículo, le pregunté si se sentía perdido acerca de los robots.txt en los sitios de WordPress. Con suerte, las cosas están un poco más claras para ti. Recuerde: robots.txt es solo un simple archivo de texto que le dice a los robots de búsqueda (agentes de usuario) a dónde pueden y no deben ir.

Aunque robots.txt probablemente ya esté en su instalación de WordPress, puede editarlo utilizando un complemento de WordPress (como Yoast SEO) o a través del sistema de administración de archivos de su host y espero que a través de mi artículo, tenga una mejor idea de cómo hacerlo en su sitio.

Hay muchos usos para los robots.txt archivo. Si bien puede que no sea realmente un archivo para seo y no afecte directamente el rango, ayuda a asegurarse de que su sitio y las páginas correctas se rastreen, indexen, clasifiquen para sus términos objetivo en los resultados de los motores de búsqueda y ganen tráfico de los motores de búsqueda. Esto, en sí mismo, es razón suficiente para configurar su archivo robots.txt para su sitio de WordPress.

¿Buscar otro fue para ayudarlo con sus estrategias de optimización de motores de búsqueda y ganar tráfico orgánico a su sitio? ¿Quieres ser un experto en SEO y buscas más información SEO? Echa un vistazo a nuestro otro contenido sobre SEO y permítanos ayudarte a clasificarte en Google y otros motores de búsqueda importantes.